📚 Les Fondements du RAG – Comprendre les Bases

🤖 Qu’est-ce que le RAG ?

Le RAG (Retrieval Augmented Generation) est une approche architecturale innovante qui combine la puissance des grands modèles de langage (LLM) avec l’accès à des données personnalisées. Le principe est simple mais redoutable d’efficacité :

- On récupère des données ou documents pertinents par rapport à une question posée

- On les fournit comme contexte au LLM

- Le LLM génère une réponse ultra-précise et spécifique en s’appuyant sur ces données

C’est un peu comme si on donnait un livre ouvert au LLM pendant un examen, plutôt que de compter uniquement sur ce qu’il a mémorisé pendant son entraînement. 📚

🔧 Architecture générique d’un RAG

L’architecture générique d’un système RAG se décompose en plusieurs étapes clés :

- 1️⃣ Préparation des données : Les documents sont collectés et subissent un prétraitement initial (gestion des données personnelles, filtrage, etc). Pour pouvoir être utilisés dans un système RAG, les documents doivent être découpés en morceaux (chunks) de taille appropriée en fonction du modèle d’embedding choisi et de la taille maximale acceptée par le LLM en aval. Ce chunking permet d’optimiser la pertinence du contenu.

- 2️⃣ Indexation des données : Des embeddings sont générés pour chaque chunk de document et stockés dans une base de données vectorielle. Un embedding est une représentation vectorielle du contenu textuel qui capture sa sémantique. Stocker les embeddings dans une base de données vectorielle permet ensuite une recherche rapide par similarité.

- 3️⃣ Récupération des données pertinentes : Lorsqu’une requête utilisateur arrive, elle est elle-même transformée en embedding. Une recherche par similarité est alors effectuée dans la base de données vectorielle pour récupérer les chunks de documents les plus proches de la requête.

- 4️⃣ Génération de la réponse : Les chunks de texte pertinents récupérés sont concaténés à la requête initiale pour former un prompt enrichi qui est envoyé au LLM. Grâce à ce contexte supplémentaire, le LLM est capable de générer une réponse beaucoup plus spécifique et factuelle qu’avec la seule requête utilisateur.

L’approche RAG permet donc de combiner la puissance des LLM pour la compréhension du langage et la génération de texte avec une base de connaissances personnalisée maintenue à jour. Cela ouvre la voie à de nombreuses applications métiers nécessitant des réponses précises basées sur des données propres à l’organisation.

❌ Les Limites des LLM sans RAG

Les LLM souffrent de plusieurs limitations intrinsèques que le RAG permet de pallier.

- 🤥 Tendance à produire des « hallucinations » : Les LLM peuvent générer des affirmations qui semblent plausibles mais qui sont en réalité incorrectes ou incohérentes avec les faits réels. Cela est dû au fait que leur connaissance est limitée aux données d’entraînement, qui peuvent être incomplètes, biaisées ou obsolètes. Les LLM n’ont pas de compréhension réelle des concepts et peuvent donc combiner des informations de manière incorrecte.

- 📚 Incapacité à citer des sources / manque de transparence : Les LLM génèrent du texte sans pouvoir indiquer d’où proviennent les informations utilisées. Ils ne peuvent pas fournir de références ou de preuves pour étayer leurs affirmations, ce qui rend difficile l’évaluation de la crédibilité et de la fiabilité de leurs réponses. Cette absence de traçabilité est problématique pour des applications nécessitant une grande précision factuelle.

- 🧩 Difficulté à raisonner sur des contextes longs : Les LLM ont une fenêtre de contexte limitée, c’est-à-dire qu’ils ne peuvent traiter qu’une quantité limitée de texte à la fois. Cela les empêche de raisonner sur des documents longs ou de combiner des informations provenant de plusieurs sources. Les LLM peuvent donc avoir du mal à répondre à des questions nécessitant une compréhension globale d’un sujet.

- ⏳ Connaissances figées après l’entraînement : Une fois qu’un LLM a été entraîné, ses connaissances sont figées et ne peuvent pas être mises à jour sans ré-entraîner entièrement le modèle. Cela signifie que les LLM ne peuvent pas s’adapter à de nouvelles informations ou à des changements dans le monde réel. Leurs réponses peuvent devenir obsolètes ou incorrectes avec le temps.

- 🎲 Contrôle limité sur les sorties : Les LLM génèrent du texte de manière probabiliste en se basant sur les patterns observés dans les données d’entraînement. Il est donc difficile de contrôler précisément ce qu’ils vont générer. Les LLM peuvent produire des sorties inappropriées, biaisées, incohérentes ou factuellement incorrectes, ce qui limite leur utilisation dans des applications critiques.

- 💸 Coûts d’entraînement et d’inférence élevés : Les LLM sont des modèles très volumineux contenant des milliards de paramètres. Leur entraînement nécessite d’énormes ressources de calcul et peut coûter très cher. L’inférence (génération de texte) est également coûteuse en calcul. Ces coûts limitent la capacité à améliorer les performances des LLM en augmentant leur taille.

- 🎲 Dépendance à la qualité des données d’entraînement : Les performances d’un LLM dépendent fortement de la qualité et de la couverture des données utilisées pour l’entraîner. Si les données sont biaisées, incomplètes ou de mauvaise qualité, le LLM reflétera ces défauts. Pour certaines applications spécialisées, il peut être difficile de constituer un jeu de données d’entraînement adéquat, ce qui limite l’utilité des LLM.

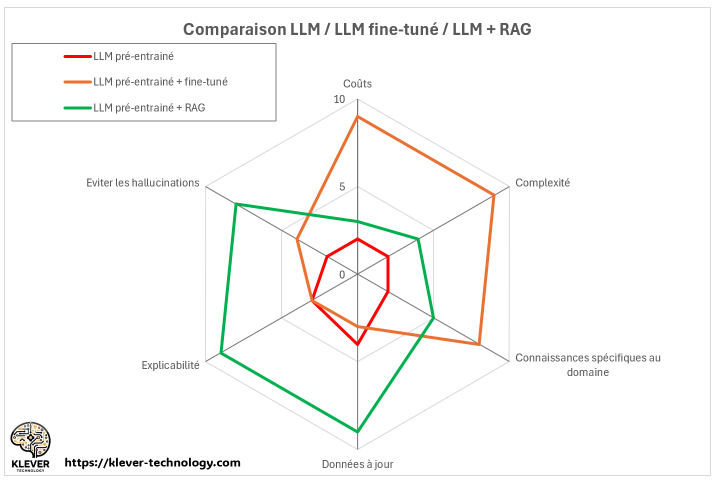

🤜🤛 Fine-Tuning vs RAG : Le Match des Techniques d’Optimisation des LLM

🥊 Fine-Tuning : Spécialiser le Modèle

Le fine-tuning consiste à spécialiser un modèle de langage pré-entraîné sur un domaine précis en le ré-entraînant sur un jeu de données spécifique. Cela permet d’adapter les capacités générales du LLM à une tâche particulière.

✅ Avantages :

- Améliore les performances sur la tâche cible grâce à la spécialisation

- Réduit le temps et les ressources par rapport à un entraînement from scratch

- Fonctionne même avec un jeu de données de taille limitée

⚠️ Inconvénients :

- Nécessite des données annotées de qualité, qui peuvent être coûteuses

- Risque de sur-apprentissage sur le jeu de données de fine-tuning

- Perte potentielle des capacités de généralisation du modèle pré-entraîné

- Requiert des ressources de calcul significatives

🔍 RAG : Augmenter avec des Connaissances Externes

Le RAG couple le LLM avec un système de recherche d’information. Au lieu de modifier les paramètres internes, il donne accès à une base de connaissances externe pour récupérer des informations pertinentes lors de l’inférence.

✅ Avantages :

- Exploite des connaissances à jour sans avoir à ré-entraîner le modèle

- Fournit des réponses basées sur des sources vérifiables, améliorant la confiance

- Réduit le risque de génération d’informations incorrectes ou incohérentes

- S’adapte facilement à de nouveaux domaines en changeant la base de connaissances

⚠️ Limitations :

- Dépend fortement de la qualité et de l’exhaustivité de la base de connaissances

- Introduit une complexité et une latence liées à la recherche d’information

- Ne modifie pas les capacités intrinsèques du LLM sous-jacent

🤝 L’Union Fait la Force

En pratique, le fine-tuning et le RAG sont deux approches complémentaires qui peuvent être combinées avec succès :

- Le fine-tuning spécialise le modèle sur un domaine et améliore ses performances

- Le RAG lui apporte des connaissances à jour issues de sources externes

Une approche hybride consiste à fine-tuner le LLM puis à le coupler avec un système RAG pour les requêtes nécessitant des informations factuelles précises et récentes.Le choix entre fine-tuning et RAG dépend donc du cas d’usage, des données disponibles et des contraintes de l’application. Dans tous les cas, ces deux techniques permettent de tirer le meilleur parti des LLM pré-entraînés en les adaptant à des besoins spécifiques. 🎯

🏦 Des Cas d’Usage Concrets pour la Finance

Les applications du RAG peuvent être multiples pour les banques et assurances :

🤝 Chatbots personnalisés qui donnent des réponses sur-mesure basées sur les contrats et documents du client

📑 Analyse automatisée de contrats d’assurance complexes pour répondre aux questions précises des clients

📈 Intégration de données financières en temps réel pour aider à la décision d’investissement

🔍 Résumé de documents pour accélérer l’analyse de risque de crédit ou de marché

🕵️ Détection de fraudes en analysant de grandes quantités de données financières

⚖️ Évaluation des risques clients en explorant automatiquement leur historique

🆘 Assistance aux conseillers et gestionnaires de sinistres en leur permettant d’interroger rapidement la documentation

🔎➕📑 Un moteur de recherche interne pour permettre aux employés de trouver facilement des réponses à leurs questions (RH, conformité, etc) dans la documentation interne de l’entreprise.

Bref, le RAG ouvre un champ des possibles immense pour exploiter intelligemment les données propres à chaque entreprise financière, tout en bénéficiant de la puissance des LLM. 🎉

👉 Passez à l’Action

Vous voulez tirer parti du framework RAG pour automatiser vos processus, améliorer l’expérience client et prendre de meilleures décisions ?Chez Klever Technology, nous pouvons vous accompagner dans la mise en place d’architectures RAG complexes et adaptées à vos besoins métiers. Contactez-nous dès maintenant pour échanger sur votre projet. 📞

0 commentaires